Los vídeos donde un rostro se cambia por otro usando un ordenador son cada vez más frecuentes. Los Deepfakes son peligrosos, ya que pueden engañar a muchas personas haciéndoles creer que alguien ha dicho algo específico, cuando en realidad se trata de otra persona «camuflada» digitalmente.

El problema es que cada vez es más difícil identificar si un vídeo es falso o no, ya que los deepfakes, que usan Inteligencia Atificial para adaptar perfectamente la forma y color del rostro, así como los movimientos de labios y músculos faciales en general, están cada vez más a manos de cualquier persona, no solo de «bromistas» con grandes ordenadores.

Ahora hay un nuevo método que puede ayudar a identificar una mentira, un proceso realizado por informáticos de UC Riverside que puede detectar expresiones faciales manipuladas con mayor precisión que los métodos actuales.

Los métodos actuales consiguen identificar más o menos bien cuando cambian un rostro por el de otra persona, pero suelen dar errores cuando lo que hacen es cambiar la expresión facial de alguien. Si modificamos un vídeo para que un sujeto pase de estar triste a alegre, por ejemplo, las herramientas actuales no podrían identificarlo, y el resultado puede ser igualmente peligroso (imaginad a un político riendo frente a la amenaza de otro).

Usar videos manipulados para influir en las opiniones políticas o sociales es cada vez más común, y eso es lo que ha hecho que Amit Roy-Chowdhury, profesor de ingeniería eléctrica e informática de la Facultad de Ingeniería de Bourns, junto a sus compañeros, decidiera trabajar en un método más fiable.

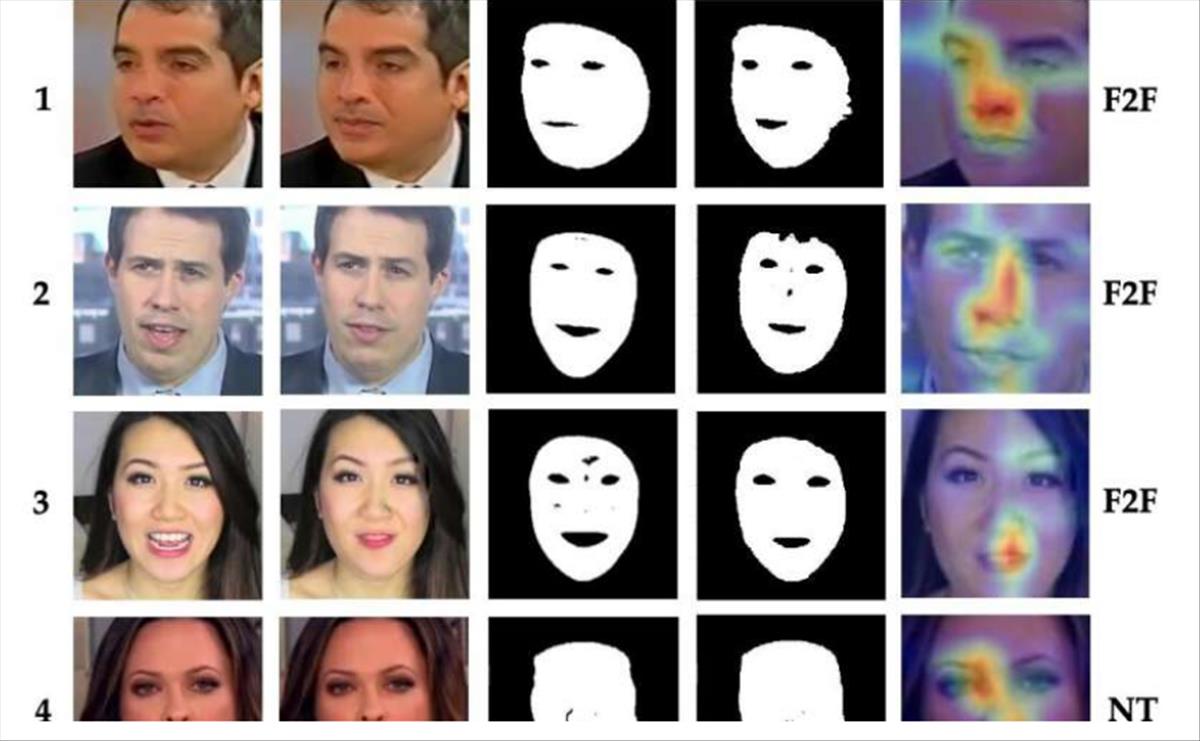

Lo que hacen es dividir la tarea en dos componentes dentro de una red neuronal profunda. La primera diferencia las expresiones faciales y envía información sobre las regiones que contienen la expresión, como la boca, los ojos o la frente. La segunda obtiene esos datos y trabaja en la detección y localización de manipulaciones.

Lo han llamado «Detección de Manipulación de Expresión», y puede detectar y localizar las regiones específicas dentro de una imagen que han sido alteradas.

El sistema se presentó en la Conferencia de invierno de 2022 sobre aplicaciones de visión artificial, ahora solo falta que se incluya en los softwares comunes que tenemos en casa, para que podamos identificar una mentira sin tener que pedir ayuda de los universitarios.

Fuente info

Autor: Juan Diego Polo